11 月 25 日消息,科技媒體 livescience 昨日(11 月 24 日)發布博文,報道稱來自芬蘭阿爾托大學的研究團隊成功演示名為“并行光學矩陣-矩陣乘法器”(POMMM)的新一代光學計算基礎架構,旨在解決人工智能(AI)模型訓練和執行中的核心瓶頸。

IT之家援引博文介紹,現代 AI 模型,尤其是大語言模型(LLM),其性能受限于處理“張量”(Tensor)數據的速度。

Tensor 是 AI 模型中用于組織數據的加權結構,處理速度的上限直接決定了模型規模的上限。POMMM 架構的出現,為突破這一限制提供了全新思路。

傳統光計算雖然在小規模下比電子計算更快、更節能,但存在一個致命缺陷:難以并行處理。與可以大規模串聯以指數級提升算力的圖形處理器(GPU)不同,大多數光學系統只能線性運行。

因此,盡管光計算潛力巨大,但開發者普遍傾向于選擇 GPU 的并行處理優勢。像 OpenAI、Google 等公司開發的頂級 AI 模型,正是依賴數千塊 GPU 并行運行才得以實現。

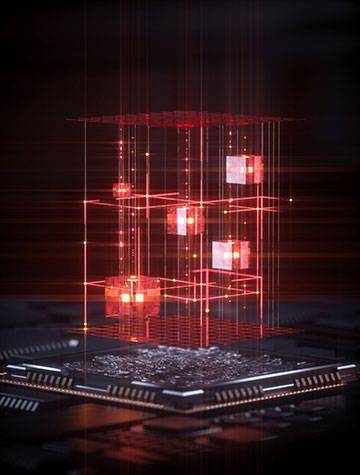

POMMM 技術能夠利用單次相干光的傳播過程,完成整個矩陣與矩陣的乘法運算。其核心原理在于,通過空間光調制器將數字張量編碼為光的相位和振幅,光束穿過實現傅里葉變換的透鏡組后,運算結果以干涉圖像的形式被高速探測器捕捉。整個算術過程在光的“飛行”中瞬間完成,無需電子環路或內存讀取,實現了物理層面的“自然同步計算”。